谁是AI之王? 聊聊备受争议的AI评测与崛起的LMArena

撰稿|张珺玥

在大模型激战的当下,究竟谁更强?是OpenAI的GPT,还是Anthropic的Claude?是谷歌的Gemini,还是中国的DeepSeek?

当AI模型排行榜开始被各种刷分作弊之后,谁家大模型最牛这个问题就变得非常主观,直到一家线上排行榜诞生,它叫:LMArena。

在文字、视觉、搜索、文生图、文生视频等不同的AI大模型细分领域,LMArena上每天都有上千场的实时对战,由普通用户来匿名投票选出哪一方的回答更好。最近以来,很多AI研究者都纷纷发声,认为大模型竞赛的下半场,最重要的事情之一就是重新思考模型评估。

因为当技术创新趋于饱和,真正拉开差距的,可能将不再是谁的参数更多、推理更快,而是谁能更准确地衡量、理解模型的智能边界。

在大模型评测上,传统的Benchmark(基准测试)究竟存在什么问题,是已经过时了吗?LMArena的竞技场模式为什么会被视为一种新的标准?它的技术机制、公平性和商业化隐藏着怎样的挑战?而下一代的大模型评测,又可能会走向哪里?

(本文为视频改写,欢迎大家收看以下视频)

01

题库泄露、数据污染传统Benchmark为何失灵?

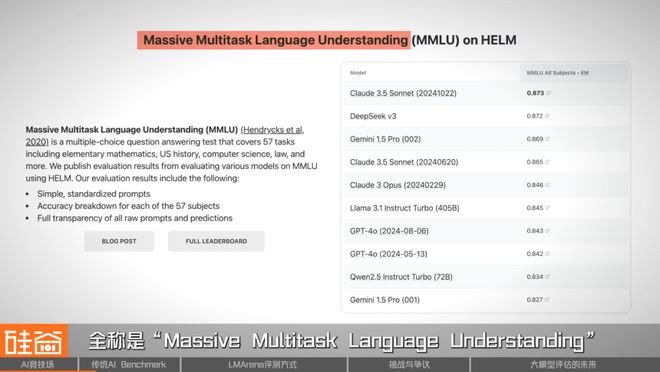

在LMArena之前,AI大模型是怎么被评估的呢?方式其实非常“传统”。研究者们通常会准备一组固定的题库,比如MMLU、BIG-Bench、HellaSwag等等。这些名字普通人看起来很陌生,但在AI学术界几乎家喻户晓。

这些题库涵盖学科、语言、常识推理等多个维度,通过让不同模型作答,再根据答对率或得分来对模型进行比较。

比如MMLU,全称是“MassiveMultitaskLanguageUnderstanding”,它涵盖了从高中到博士级别的57个知识领域,包括历史、医学、法律、数学、哲学等等,模型既需要回答像“神经网络中的梯度消失问题如何解决”的技术问题,也需要回答“美国宪法第十四修正案的核心内容是什么”的社会科学问题,学科跨度很大。

BIG-Bench更偏向推理和创造力,比如让模型解释冷笑话、续写诗歌或完成逻辑填空。HellaSwag则专门用来测试模型对日常情境的理解能力,比如“一个人正在打开冰箱,接下来最可能发生什么?”等等。

这些Benchmark在过去二十年几乎主导了整个AI研究领域。它们的优点显而易见:标准统一、结果可复现。学术论文只要能在相关公开数据集上刷新分数,就意味着“性能更强”。而AI的上半场也正是在这种“比成绩”的节奏下高速发展起来的。

但这些早期的Benchmark是静态的,多以单轮问答、选择题形式为主,题目结构简单、评测维度明确,便于统一打分和横向比较。

然而,当模型的能力越来越强、训练数据越来越庞大时,这些Benchmark的局限开始显现。

首先是“题库泄漏”,很多测试题早就出现在模型的训练语料里。于是,一个模型在这些测试上得分再高,也不代表它真的“理解”了问题,只能说明它“记住”了答案。

其次,Benchmark永远测不出模型在真实交互中的表现,它更像是一场封闭的考试,而不是一次开放的对话。

华盛顿大学助理教授、英伟达首席研究科学家,同时也是LMArena早期框架搭建参与者朱邦华在采访中表示,正是因为传统的静态Benchmark所存在的过拟合、数据污染等问题,才催生出了Arena这种新的模型测评方式的出现。

02

从伯克利实验室到全球擂台赛LMArena如何运作?

2023年5月,LMArena的雏形诞生于由全球顶尖学府组成的非营利性开放研究组织LMSYS。核心成员包括LianminZheng、YingSheng、Wei-LinChiang等人。

当时他们刚刚发布了开源模型Vicuna,而斯坦福大学在此之前也推出了另一个类似的,叫Alpaca。因为这两个模型都是基于大型语言模型进行微调的开源项目,于是LMSYS的团队想知道,从性能和表现上来看,究竟谁更胜一筹?

当时并没有合适的评测方法能回答这个问题。LMSYS团队尝试了两种方法:

一是尝试让GPT-3.5作为评委,对不同模型生成的答案打0到10分,这种方法后来演化成MT-Bench(Model-TestBenchmark)。

另一种方式是采用人类比较(PairwiseComparison),即随机挑选两个模型,针对同一个问题分别生成回答,再让人类评审选择哪一个更好。

最终,第二种方式被证明更可靠,并由此诞生了Arena的核心机制。

基于此,他们首先搭建了一个实验性网站ChatbotArena,也就是今天的LMArena的前身。在传统的基准测试里,模型是在预设题库中答题,而在ChatbotArena上,它们则要“上场打擂台”。

当用户输入一个问题后,系统会随机分配两个模型,比如GPT-4和Claude,但用户并不知道自己面对的是谁。两边模型几乎同时生成回答,用户只需投票:左边好,还是右边好?等投票完成后,系统才会揭示它们的真实身份。这个过程被称作“匿名对战”。

投票结束后,系统基于Bradley–Terry模型实现Elo式评分机制,分数会根据胜负实时变化,从而形成一个动态排行榜。

Elo排名机制最早来自国际象棋。每个模型都有一个初始分数,每次赢一场就涨分,输一场就扣分。随着对战次数增加,分数会逐渐收敛最终形成一个动态的模型排行榜。

这种机制的妙处在于,它让评测变成了一场“真实世界的动态实验”,而不再是一次性的闭卷考试。除此之外,LMArena不仅仅只是“让模型打架”,它背后还有一个独特的“人机协同评估框架”。

这个框架的逻辑是用人类投票去捕捉“真实偏好”,再通过算法去保证“统计公平”。平台会自动平衡模型的出场频率、任务类型和样本分布,防止某个模型因为曝光量大而被“高估”。换句话说,它让评测既开放又可控。更重要的是,ChatbotArena的所有数据和算法都是开源的,任何人都可以复现或分析结果。

作为LMArena早期搭建的核心参与者,朱邦华告诉我们,LMArena的技术本身并不是新算法,更多的是经典统计方法的工程化实现。它的创新点不在于模型本身,而在于系统架构与调度机制。

LMArena这种“匿名对战+动态评分”的方式,被认为是从静态Benchmark向动态评测的一次跃迁。它不再追求一个最终分数,而是让评测变成一场持续发生的“真实世界实验”。

它就像是一个实时运行的AI智能观测站。在这里,模型的优劣不再由研究者定义,而是由成千上万用户的选择来共同决定。

2023年12月底,前特斯拉AI总监、OpenAI早期成员AndrejKarpathy在X(推特)上发了一条关于LMArena的推文,称“目前他只信任两个LLM评测方式:ChatbotArena和r/LocalLlama”,给ChatbotArenaI社区中收获到了第一批“流量”。

2023年底到2024年初,随着GPT-4、Claude、Gemini、Mistral、DeepSeek等模型的陆续接入ChatbotArena,平台的访问量迅速增长。研究者、开发者、甚至普通用户,都在这里观察模型的“真实表现”。

到了2024年底,平台的功能和评测任务开始扩展,除了语言模型的对话任务,团队还逐渐涉及到了大模型的“细分赛道”,陆续上线了专注代码生成的CodeArena、专注搜索评估的SearchArena、专注多模态图像理解的ImageArena等子平台。

为了体现评测范围的扩展,平台也在2025年1月正式从ChatbotArena更名为LMArena(LargeModelArena)。几个月前,谷歌NanoBnana的爆火也是让更多普通用户关注到了LMArena。至此,LMArena从一个研究者间的小众项目,彻底成为AI圈乃至公众视野中的“大模型竞技舞台”。

不久前爆火的谷歌最新文生图模型NanoBanana,它其实最早以神秘代号出现、并引发“破圈式”关注的地方就是LMArena。

最近网友们发现谷歌又故技重施,传闻已久的Gemini3.0被发现已经出现在了LMArena上。根据网友们的测试反馈,Gemini3.0Pro的代号应该是lithiumflow,而Gemini3.0Flash是orionmist。据说能“读表”、能作曲和演奏,能力再一次全方位飞升。

不难看出,在正式发布新模型前,让它们在LMArena上跑一跑,似乎已经成为了谷歌的惯例操作。而实际上,各家模型其实早就已经把LMArena当作了“常规赛场“,用来测试普通用户最真实的反馈。

除了Google,OpenAI、Anthropic、Llama、DeepSeek、混元、千问……几乎所有的头部模型都在LMArena“打擂台”。

03

刷榜、偏见与资本

LMArena光环之下的“公平性”危机

LMArena的火爆,让它几乎成了大模型评测的“非官方标准”,但和所有新的实验一样,随着光环越来越大,它也受到了越来越多的质疑。

首先是公平性问题。在LMArena的匿名对战机制中,用户的投票结果直接决定模型的Elo排名,然而,这种“人类评判”的方式,并不总是中立的。

不同语言背景、文化偏好甚至个人使用习惯,都会影响投票结果。一些研究发现,用户更倾向于选择“语气自然”“回答冗长”的模型,而不一定是逻辑最严谨、信息最准确的那一个。这意味着,模型可能因为“讨人喜欢”而获胜,而非真的更聪明。

2025年初,来自Cohere、斯坦福大学以及多家研究机构的团队联合发布了一篇研究论文,系统分析了LMArena的投票机制与数据分布。研究指出,Arena的结果与传统benchmark分数之间并非强相关,而且存在“话题偏差”与“地区偏差”,也就是说不同类型的问题、或不同用户群体的投票,可能显著改变模型的排名。

此外,还有“游戏化”与“过拟合”的问题。当LMArena的排名被广泛引用、甚至被媒体视为模型能力的“权威榜单”时,一些公司开始为“上榜”专门优化模型的回答风格。比如更积极地使用模糊语气、提升字数密度、或在提示工程上精细调教,以希望“赢得投票”。

Cohere的那篇研究论文就明确指出,大型供应商在获取用户数据方面拥有显著优势。通过API接口,它们能够收集到大量的用户与模型交互的数据,包括提示和偏好设置。

然而,这些数据并未被公平地共享,62.8%的所有数据都流向了特定的模型提供商。比如Google和OpenAI的模型分别获得了Arena上约19.1%和20.2%的全部用户对战数据,而其他83个开源模型的总数据占比仅为29.7%。

这使得专用模型供应商能够利用更多的数据进行优化,甚至可能针对LMArena平台进行专门优化,导致过度拟合特定指标,从而提升排名。

一个典型例子是Meta的“刷榜事件”。今年4月,Meta在LMArena上提交的Llama4Maverick模型版本,表现超越GPT-4o与Claude,跃居榜单第二。但随着Llama4大模型开源版上线,开发者们发现其真实效果的表现并不好,因此质疑Meta疑似给LMArena提供了经过专门针对投票机制的优化的“专供版”模型,导致Llama4的口碑急转直下。

舆论爆发后,LMArena官方更新了排行榜政策,要求厂商披露模型版本与配置,以确保未来评估的公平性和可重复性,并将把公开的HuggingFace版本的Llama4Maverick加入排行榜进行重新评估,但事件仍然在当时引发了业内关于“评测公正性”的激烈讨论。

除了系统和技术上的挑战,LMArena的商业化也让它的中立性受到质疑。

2025年5月,LMArena背后的团队正式注册公司“ArenaIntelligenceInc.”,并宣布完成1亿美元种子轮融资,投资方包括a16z、UCInvestments和Lightspeed等。

这也意味着,LMArena正式从一个开源研究项目,转变为具备商业化运营能力的企业。公司化后,平台可能开始探索数据分析、定制化评测和企业级报告等商业服务。

这一转变,也让业界开始担忧,当资本介入、客户需求与市场压力叠加时,LMArena是否还能保持最初“开放”与“中立”?它的角色是否会从“裁判”变成“利益相关方”?

在LMArena之后,大模型评测似乎进入了一个新的拐点。它解决了过去Benchmark静态、封闭的问题,却也暴露出新的矛盾。那就是当评测数据、用户偏好、甚至投票机制,都可能成为商业竞争的一部分,我们该如何界定“公平”?究竟什么样的模型评估方式,才是当前所需要的呢?

04

从“实战”到“动静结合”

未来评测走向何方?

实际上,LMArena的出现,并不意味着传统的Benchmark已经过时。在它之外,静态的Benchmark仍然在持续演化。

近几年来,基于传统的Benchmark,研究者陆续推出了难度更高的版本,比如MMLUPro、BIG-Bench-Hard等。此外,一些全新的、聚焦于细分领域的Benchmark也在被不断创造出来,比如数学与逻辑领域的AIME2025、编程领域的SWE-Bench、多智能体领域的AgentBench等等。

这些新的Benchmark,不再只是“考知识”,而是在模拟模型在真实世界中的工作方式。从过去单一的考试题集,演化为了一个庞大而多层次的体系:有的评推理,有的测代码,有的考记忆与交互。

与此同时,评测也正在进一步走向“真实世界”。比如最近一家名为AlphaArena的新平台就引发了大量关注。它由创业公司nof1.ai推出,在首轮活动中,平台选取了Deepseek、Genimi、GPT、Claud、Gork和千问等六大模型在真实的加密货币交易市场中进行对战。

它给了每个模型相同的资金和Prompt,让它们独立决策和交易,最终以实际收益和策略稳定性作为评测依据。结果是:DeepSeek竟然赢了!不愧是量化基金母公司下面做出来的AI模型。

虽然这个对战更多是“噱头”为主,大语言模型去预测股市现在还是非常不靠谱的,但AlphaArena的这种“实战式评测”再一次跳出了传统的题库和问答框架,让模型在动态、对抗的环境中被检验,被视为是继LMArena之后,又一次尝试让AI在开放世界中接受考验的实验。

不过,AlphaArena更偏向特定任务领域的真实验证,其结果也更难复现与量化。

实际上,这些Arena出现的意义,也并非是要取代静态Benchmark,而是为这个体系提供一面镜子,试图把静态测试中难以衡量的人类偏好与语义细节,重新引入到评测系统中。

也就是说,未来的模型评估,不再是静态Benchmark和Arena之间的二选一,而更可能是一种融合式的评测框架。静态benchmark负责提供可复现、可量化的标准;而Arena负责提供动态、开放、面向真实交互的验证。两者结合,进而构成衡量智能的完整坐标系。

在这个评估体系中,目前最重要、也具挑战的部分是什么呢?朱邦华认为,随着大模型能力提升,原有测试集“太简单”的问题愈发突出,Arena的自动难度过滤提出了阶段性解决方案,但真正的方向是由人类专家与强化学习环境共同推动的高难度数据建设。

朱邦华谈到,大模型评估的未来,不会是线性的改进,而是螺旋式的共演。一边是不断变强的模型,另一边是不断变难的评测。模型的突破,迫使评测体系升级;而新的评测,又反过来定义了模型的能力边界。而高质量的数据成为了连接两者的中轴。

除了数据质量至关重要之外,朱邦华还认为,研究者不仅要“造benchmark”,更要学会“选benchmark”。如何在成百上千个数据集中进行筛选、组合与聚合,建立一个兼顾统计有效性与人类偏好的聚合框架,也将是接下来几年重要的工作方向。

正如OpenAI的研究员姚顺雨在他的博客《TheSecondHalf》中写道:AI的上半场,是关于“如何训练模型”;而下半场,则是“如何定义与衡量智能”。如今,评测不再只是AI模型性能的终点,而正在成为AI向前发展的“核心科学”。

究竟什么样的评估方法才是最优的,或许我们目前还无法下定论。但能够预见的是,这将是一场持续进行的实验:我们需要在成百上千个benchmark中找到那些真正有价值的任务,然后在类似于LMArena这样的“竞技场”中去捕捉人类偏好的信号,最后再将它们结合成一个动态、开放、可信的智能测量体系。

也许在那一天,我们不再需要问“哪个模型最强?”而是去真正探索“智能,究竟是什么?”欢迎大家给我们留言,你们觉得LMArena的方式是否是衡量模型的最好标准?

视频有视觉和音乐的加持,更能呈现出这些精彩的故事细节。请跳转至硅谷101[视频号]收看完整版

注:部分图片来源于网络

[本期节目不构成任何投资建议]

[视频播放渠道]

海外:Youtube

[创作团队]

监制|泓君陈茜

撰稿|张珺玥

主持|陈茜

剪辑|Frentee橘子

动效|踹

运营|王梓沁孙泽平何源清